elasticsearch安装中文分词器插件smartcn

发布时间:『 2018-01-16 17:39』 博客类别:elasticsearch

elasticsearch安装中文分词器插件smartcn

elasticsearch默认分词器比较坑,中文的话,直接分词成单个汉字。

我们这里来介绍下smartcn插件,这个是官方推荐的,中科院搞的,基本能满足需求;

还有另外一个IK分词器。假如需要自定义词库的话,那就去搞下IK,主页地址:https://github.com/medcl/elasticsearch-analysis-ik

smartcn安装比较方便,

直接用 elasticsearch的bin目录下的plugin命令;

先进入elasticsearch的bin目录

然后执行 sh elasticsearch-plugin install analysis-smartcn

-> Downloading analysis-smartcn from elastic

[=================================================] 100%

-> Installed analysis-smartcn

下载 自动安装;

(注意,假如集群是3个节点,所有节点都需要安装;不过一般都是先一个节点安装好所有的东西,然后克隆几个节点,这样方便)

安装后 plugins目录会多一个smartcn文件包;

安装后,我们需要重启es;

然后我们来测试下;

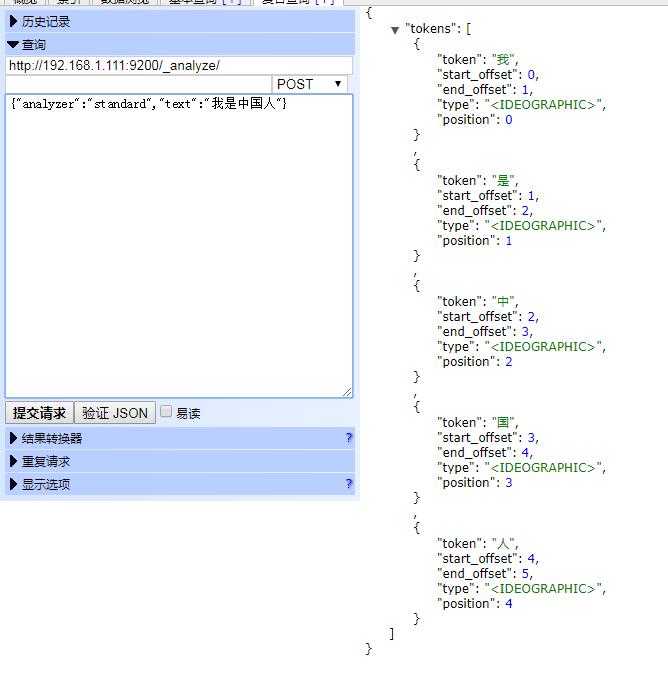

POST http://192.168.1.111:9200/_analyze/

{"analyzer":"standard","text":"我是中国人"}

执行标准分词器;

结果:

中文都是单个字了;

很不符合需求;

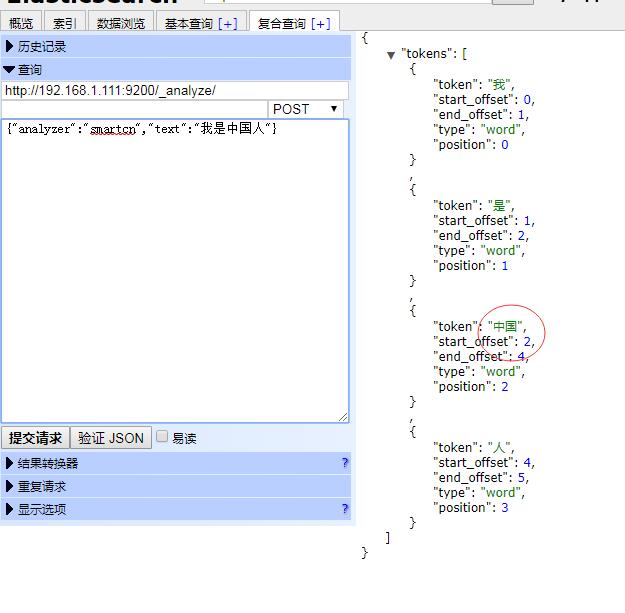

我们用下 smartcn;

{"analyzer":"smartcn","text":"我是中国人"}

执行结果:

我们发现 中国 编程个单个词汇;

Java1234_小锋

(知识改变命运,技术改变世界)

- Java核心基础(145)

- 007项目(0)

- SVN(22)

- QQ第三方登录(6)

- mybatis-plus(20)

- Mycat(30)

- Layui(2)

- Mysql(2)

- Docker(35)

- Dubbo(7)

- SpringCloud(33)

- Tomcat(6)

- 支付宝接口(3)

- NodeJs(1)

- IDEA(24)

- SpringBoot(11)

- 微信扫码登录(4)

- Git(50)

- Nginx(24)

- Vue.js(50)

- jsoup(6)

- shiro(1)

- elasticsearch(31)

- Redis(17)

- maven(6)

- 活动(20)

- hibernate(1)

- EhCache缓存框架(4)

- webservice(10)

- CAS单点登录(7)

- log4j日志(8)

- IT之路(26)

- activiti(26)

- centos(25)

- 随心生活(19)

- java爬虫技术(14)

- 网站SEO(2)

- httpclient(7)

- htmlunit(10)

- 2026年01月(1)

- 2021年10月(1)

- 2021年02月(3)

- 2020年11月(3)

- 2020年10月(4)

- 2020年09月(7)

- 2020年08月(18)

- 2020年07月(21)

- 2020年06月(37)

- 2020年05月(17)

- 2020年04月(12)

- 2020年03月(10)

- 2020年02月(14)

- 2020年01月(12)

- 2019年12月(15)

- 2019年11月(27)

- 2019年10月(5)

- 2019年09月(1)

- 2019年08月(4)

- 2019年07月(28)

- 2019年06月(16)

- 2019年05月(4)

- 2019年04月(3)

- 2019年03月(2)

- 2019年02月(7)

- 2019年01月(20)

- 2018年12月(2)

- 2018年11月(5)

- 2018年10月(30)

- 2018年09月(11)

- 2018年08月(5)

- 2018年07月(9)

- 2018年06月(4)

- 2018年05月(4)

- 2018年04月(3)

- 2018年03月(7)

- 2018年02月(6)

- 2018年01月(13)

- 2017年12月(3)

- 2017年11月(10)

- 2017年10月(1)

- 2017年09月(9)

- 2017年08月(12)

- 2017年07月(19)

- 2017年06月(21)

- 2017年05月(1)

- 2017年04月(12)

- 2017年03月(13)

- 2017年02月(12)

- 2017年01月(14)

- 2016年12月(8)

- 2016年11月(25)

- 2016年10月(16)

- 2016年09月(13)

- 2016年08月(20)

- 2016年07月(12)

- 2016年06月(36)

- 2016年05月(10)

- 2016年04月(19)

- 2016年03月(14)

- 2016年02月(23)

- 2016年01月(1)

Powered by Java1234 V3.0

Copyright © 2012-2016 Java知识分享网 版权所有