Crawler4j快速入门实例

发布时间:『 2016-06-04 12:27』 博客类别:java爬虫技术

下面我们来写一个Demo,让大家快速入门crawler4j;代码中加了详细的备注,大家可以好好看看。

crawler4j中用了slf4j来记录项目运行日志信息。我们使用slf4j具体实现类log4j;

首先我们在pom.xml中加入log4j以及log4j驱动类支持;

<!-- 加入log4j支持 --> <dependency> <groupId>log4j</groupId> <artifactId>log4j</artifactId> <version>1.2.17</version> </dependency> <!-- 加入slf4j log4j驱动类 --> <dependency> <groupId>org.slf4j</groupId> <artifactId>slf4j-log4j12</artifactId> <version>1.7.21</version> </dependency>

log4j.properties配置如下:

log4j.rootLogger = debug,D,E

### debug ###

log4j.appender.D = org.apache.log4j.DailyRollingFileAppender

log4j.appender.D.File = c://logs/log.log

log4j.appender.D.Append = true

log4j.appender.D.Threshold = DEBUG

log4j.appender.D.layout = org.apache.log4j.PatternLayout

log4j.appender.D.layout.ConversionPattern = %-d{yyyy-MM-dd HH:mm:ss} [ %t:%r ] - [ %p ] %m%n

### error ###

log4j.appender.E = org.apache.log4j.DailyRollingFileAppender

log4j.appender.E.File =c://logs/error.log

log4j.appender.E.Append = true

log4j.appender.E.Threshold = ERROR

log4j.appender.E.layout = org.apache.log4j.PatternLayout

log4j.appender.E.layout.ConversionPattern = %-d{yyyy-MM-dd HH:mm:ss} [ %t:%r ] - [ %p ]然后我们先来定义一个MyCrawler

package com.java1234.crawler;

import java.util.Set;

import java.util.regex.Pattern;

import edu.uci.ics.crawler4j.crawler.Page;

import edu.uci.ics.crawler4j.crawler.WebCrawler;

import edu.uci.ics.crawler4j.parser.HtmlParseData;

import edu.uci.ics.crawler4j.url.WebURL;

/**

* 自定义爬虫类需要继承WebCrawler类,决定哪些url可以被爬以及处理爬取的页面信息

* @author

*

*/

public class MyCrawler extends WebCrawler {

/**

* 正则匹配指定的后缀文件

*/

private final static Pattern FILTERS = Pattern.compile(".*(\\.(css|js|gif|jpg"

+ "|png|mp3|mp3|zip|gz))$");

/**

* 这个方法主要是决定哪些url我们需要抓取,返回true表示是我们需要的,返回false表示不是我们需要的Url

* 第一个参数referringPage封装了当前爬取的页面信息

* 第二个参数url封装了当前爬取的页面url信息

*/

@Override

public boolean shouldVisit(Page referringPage, WebURL url) {

String href = url.getURL().toLowerCase(); // 得到小写的url

return !FILTERS.matcher(href).matches() // 正则匹配,过滤掉我们不需要的后缀文件

&& href.startsWith("http://www.java1234.com/"); // url必须是http://www.java1234.com/开头,规定站点

}

/**

* 当我们爬到我们需要的页面,这个方法会被调用,我们可以尽情的处理这个页面

* page参数封装了所有页面信息

*/

@Override

public void visit(Page page) {

String url = page.getWebURL().getURL(); // 获取url

System.out.println("URL: " + url);

if (page.getParseData() instanceof HtmlParseData) { // 判断是否是html数据

HtmlParseData htmlParseData = (HtmlParseData) page.getParseData(); // 强制类型转换,获取html数据对象

String text = htmlParseData.getText(); // 获取页面纯文本(无html标签)

String html = htmlParseData.getHtml(); // 获取页面Html

Set<WebURL> links = htmlParseData.getOutgoingUrls(); // 获取页面输出链接

System.out.println("纯文本长度: " + text.length());

System.out.println("html长度: " + html.length());

System.out.println("输出链接个数: " + links.size());

}

}

}再写一个控制器Controller:

package com.java1234.crawler;

import edu.uci.ics.crawler4j.crawler.CrawlConfig;

import edu.uci.ics.crawler4j.crawler.CrawlController;

import edu.uci.ics.crawler4j.fetcher.PageFetcher;

import edu.uci.ics.crawler4j.robotstxt.RobotstxtConfig;

import edu.uci.ics.crawler4j.robotstxt.RobotstxtServer;

/**

* 爬虫控制器

* @author

*

*/

public class Controller {

public static void main(String[] args) throws Exception {

String crawlStorageFolder = "c:/crawl"; // 定义爬虫数据存储位置

int numberOfCrawlers = 7; // 定义7个爬虫,也就是7个线程

CrawlConfig config = new CrawlConfig(); // 定义爬虫配置

config.setCrawlStorageFolder(crawlStorageFolder); // 设置爬虫文件存储位置

/*

* 实例化爬虫控制器

*/

PageFetcher pageFetcher = new PageFetcher(config); // 实例化页面获取器

RobotstxtConfig robotstxtConfig = new RobotstxtConfig(); // 实例化爬虫机器人配置 比如可以设置 user-agent

// 实例化爬虫机器人对目标服务器的配置,每个网站都有一个robots.txt文件 规定了该网站哪些页面可以爬,哪些页面禁止爬,该类是对robots.txt规范的实现

RobotstxtServer robotstxtServer = new RobotstxtServer(robotstxtConfig, pageFetcher);

// 实例化爬虫控制器

CrawlController controller = new CrawlController(config, pageFetcher, robotstxtServer);

/**

* 配置爬虫种子页面,就是规定的从哪里开始爬,可以配置多个种子页面

*/

controller.addSeed("http://www.java1234.com/");

controller.addSeed("http://www.java1234.com/a/kaiyuan/");

controller.addSeed("http://www.java1234.com/a/bysj/");

/**

* 启动爬虫,爬虫从此刻开始执行爬虫任务,根据以上配置

*/

controller.start(MyCrawler.class, numberOfCrawlers);

}

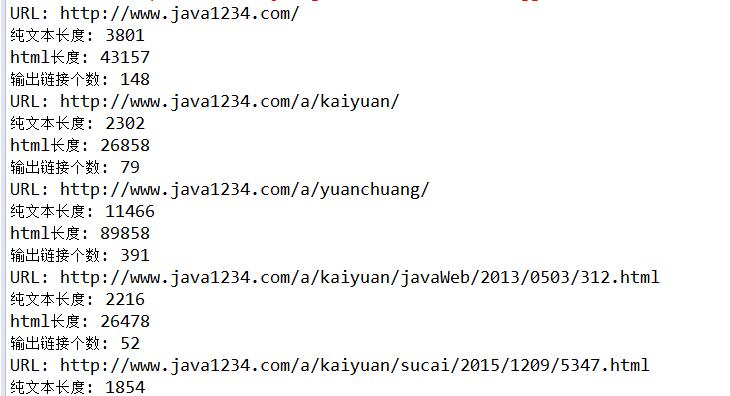

}我们运行Controller,效果如下:

这个是一个很简单的实例,大家可以根据我的注释,以及配合框架源码,好好理解下;

完整代码下载:http://pan.baidu.com/s/1gfpt2lt

上一篇:crawler4j开发环境搭建

Java1234_小锋

(知识改变命运,技术改变世界)

- Java核心基础(145)

- QQ第三方登录(6)

- mybatis-plus(20)

- Mycat(30)

- Layui(2)

- Mysql(2)

- Docker(35)

- Dubbo(7)

- 007项目(0)

- SVN(22)

- NodeJs(1)

- IDEA(24)

- SpringBoot(11)

- 微信扫码登录(4)

- Git(50)

- SpringCloud(33)

- Tomcat(6)

- 支付宝接口(3)

- jsoup(6)

- shiro(1)

- Nginx(24)

- Vue.js(50)

- 活动(20)

- hibernate(1)

- EhCache缓存框架(4)

- webservice(10)

- CAS单点登录(7)

- elasticsearch(31)

- Redis(17)

- maven(6)

- log4j日志(8)

- IT之路(26)

- activiti(26)

- centos(25)

- 随心生活(19)

- java爬虫技术(14)

- 网站SEO(2)

- httpclient(7)

- htmlunit(10)

- 2022年12月(1)

- 2021年10月(1)

- 2021年02月(3)

- 2020年11月(3)

- 2020年10月(4)

- 2020年09月(7)

- 2020年08月(18)

- 2020年07月(21)

- 2020年06月(37)

- 2020年05月(17)

- 2020年04月(12)

- 2020年03月(10)

- 2020年02月(14)

- 2020年01月(12)

- 2019年12月(15)

- 2019年11月(27)

- 2019年10月(5)

- 2019年09月(1)

- 2019年08月(4)

- 2019年07月(28)

- 2019年06月(16)

- 2019年05月(4)

- 2019年04月(3)

- 2019年03月(2)

- 2019年02月(7)

- 2019年01月(20)

- 2018年12月(2)

- 2018年11月(5)

- 2018年10月(30)

- 2018年09月(11)

- 2018年08月(5)

- 2018年07月(9)

- 2018年06月(4)

- 2018年05月(4)

- 2018年04月(3)

- 2018年03月(7)

- 2018年02月(6)

- 2018年01月(13)

- 2017年12月(3)

- 2017年11月(10)

- 2017年10月(1)

- 2017年09月(9)

- 2017年08月(12)

- 2017年07月(19)

- 2017年06月(21)

- 2017年05月(1)

- 2017年04月(12)

- 2017年03月(13)

- 2017年02月(12)

- 2017年01月(14)

- 2016年12月(8)

- 2016年11月(25)

- 2016年10月(16)

- 2016年09月(13)

- 2016年08月(20)

- 2016年07月(12)

- 2016年06月(36)

- 2016年05月(10)

- 2016年04月(19)

- 2016年03月(14)

- 2016年02月(23)

- 2016年01月(1)

Powered by Java1234 V3.0

Copyright © 2012-2016 Java知识分享网 版权所有